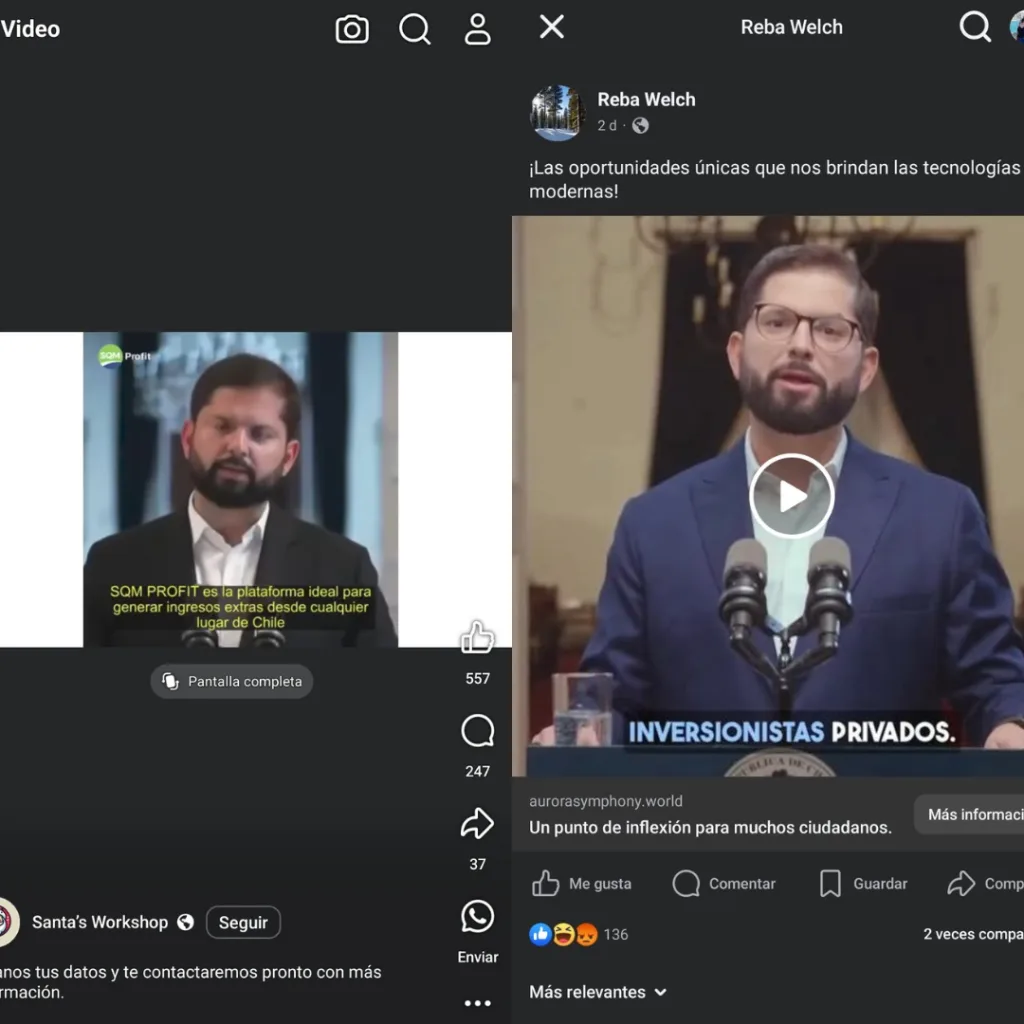

En los últimos meses, se ha detectado en Chile una preocupante tendencia delictiva: el uso de inteligencia artificial para crear «deepfakes» que suplantan la imagen y voz de figuras públicas, incluyendo al Presidente Gabriel Boric. Estos videos falsos se difunden en redes sociales como Facebook, TikTok e Instagram, donde se invita a los usuarios a invertir en supuestas empresas que resultan ser fraudulentas. Al hacer clic en estos enlaces, las víctimas son dirigidas a sitios web que solicitan información personal y bancaria, la cual es utilizada posteriormente para cometer estafas.

Si bien muchos comentarios notaron la estafa, muchos comentaban indignados por los actos que aparentemente cometía el Presidente de la República.

Esto es solo un ejemplo de nuestra realidad, vivimos en la era digital, cada vez es más común ver imágenes y videos utilizados con Inteligencia artificial, y si bien muchos lo usamos con fines de entretenimiento o ayuda, muchos ha utilizado las herramientas para timar a diferentes personas.

La deep Fake

La deep Fake es una IA que crea videos imitando casi a la perfección personas conocidas, una herramienta que muchos la utilizan con el fin de estafar, engañar y manipular a las personas, y robarles dinero o datos bancarios.

Con el avance acelerado de la inteligencia artificial, imágenes y videos falsos se han vuelto cada vez más realistas y accesibles. Hoy solo una cosa es segura, ver ya no siempre es creer. ¿Qué riesgos representa esto para la sociedad? ¿Cómo reconocer un contenido falso cuando parece tan real?

Nadie está a salvo

Últimamente en redes sociales a circulado videos provenientes de distintas páginas, entre ellas Santa’s Workshop y Reba Welch, en la cual el presidente Gabriel Boric invita a invertir una pequeña suma de dinero con la promesa de grandes intereses, anunciando que los cupos son limitados y que hemos sido seleccionado entre miles de personas.

Si bien, la imagen tiene pequeños errores como desfases entre la voz y otros pequeños detalles, no evitó que varios comentarios se manifestaran en contra el Presidente, sin embargo, muchos se dieron cuenta de la estafa y advertían a los demás para no caer en ella o no creer en su veracidad.

¿Qué riesgos representa para la sociedad?

La IA puede generar voces sintéticas que imitan a la perfección la voz de una persona. Esto puede ser utilizado en ataques de vishing (phishing de voz), donde los atacantes llaman a individuos haciéndose pasar por alguien de confianza.

Esta maliciosa practica cada vez más común, miles de cantantes, actores, influencer, youtuber, políticos y hasta familiares son víctimas de la clonación de su imagen y voz, nadie se salva.

Utilizar estas imágenes hace que las personas tenga credibilidad ante la estafa, las cuales muchas veces piden invertir o solicitar un rescate.

Otros casos reales

Muchas figuras públicas han sido utilizadas para estas estafas, entre ellos encontramos políticos como Donald Trump, Joe Beiden, y ahora Gabriel Boric; el youtuber, el jugador Cristiano Ronaldo, magnates como Elon Musk, Mark Zuckerberg, cantantes como Taylor Swift o Beyonce o actores como Tom Cruise, Dwayne Johnson, entre otros. Siendo Trump la imagen pública más utilizada para estafas, cabe destacar que muchas veces se usa la credibilidad o confianza que tienen estas figuras para lograr que los usuarios caigan.

Todos siguen una dinámica similar: solicitar dinero. En el video, la persona aparece mirando a la cámara, saluda e invita a invertir, asegurando que se trata de una oportunidad muy rentable. En otros casos, puede pedir ayuda para enfrentar una deuda o una enfermedad, apelando a la solidaridad de sus seguidores para que contribuyan a su causa.

Como evitarla

Hay diversas maneras para poder identificar un video autentico de uno falso, lo principal es ver el origen, si el video es parte de las cuentas oficiales o apareció en el algoritmo.

También hay que tener ojo en los movimientos inconsistente de los labios y los dientes, puesto que la sincronización labial puede fallar en detalles como la alineación de los dientes o el movimiento de los labios.

Otro detalle son los movimientos corporales inusuales ya que los deepfakes a menudo se centran en el rostro, lo que significa que los movimientos corporales o gestos pueden no coincidir con el diálogo o las expresiones faciales. Si el sujeto no parpadea o lo hace de manera extraña, puede ser una señal de manipulación.

Oído, las voces inanimadas y patrones de respiración inusuales, puesto que las voces clonadas suelen carecer de las variaciones naturales del habla humana, y las pausas o la respiración pueden sonar antinaturales.